缘起

小网站搭建起来也快有一个月的,我还是个想要主攻Java后端开发练习生,兴趣使然让我接触的技术点点星星面很广.写了一点东西也没几个真人来看 (ノへ ̄、) ,全当是个人笔记惹 (主要是一直也没静下来做好SEO优化).

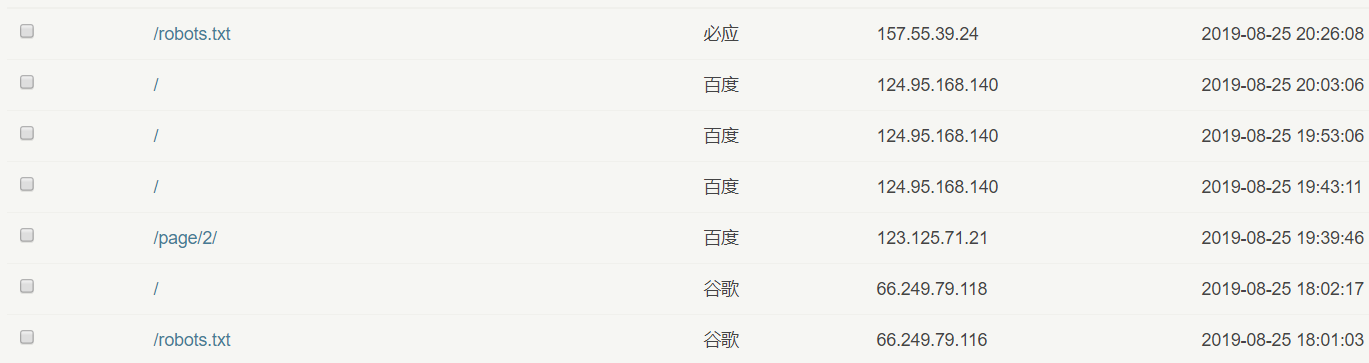

但是搜索引擎的爬虫倒是每天很亲勤快的来探望我(几天的功夫 各大搜索引擎的爬虫就爬了500余次 (。・∀・)ノ゙嗨 ).

受访地址有一个/robots.txt引起了我的注意,而且我点开之后还是404

这是个什么?为什么他们一直访问一个不存在的文本文件?

插曲

我写博文的时候,一般都会找一个收藏已久动漫的壁纸用来当大头图的,但是今天没有在囤货里找到很合适的,就直接百度了动漫壁纸,看到了下面这一张

这样子一看没有什么特别的,就是普通的动漫壁纸,但是你不知道的是,这个壁纸的文件格式是jfif

阅历浅薄,木有见过,第一反应直接问度娘.

√> 图片存储格式之一,由JPEG格式衍生而来,后缀为".jfif".JPEG本身只有描述如何将一个图像转换为字节的数据串流(streaming),但并没有说明这些字节如何在任何特定的储存媒体上被封存起来。一个由独立JPEG小组(Independent JPEG Group)所建立的额外标准,称为JFIF(JPEG File Interchange Format,JPEG档案交换格式),详细说明如何从一个JPEG串流,产出一个适合于电脑储存和传输(像是在因特网上)的档案。当有人称呼一个"JPEG档案",一般而言他是意指一个JFIF档案,或有时候是一个Exif JPEG档案。然而,也有其他以JPEG为基础的档案格式,像是JNG。

√> JPEG(发音为/jay-peg/)是一种针对相片影像而广泛使用的一种失真压缩标准方法。使用这种压缩的档案格式一般也被称为JPEG;虽然在所有平台上.jpg是最普遍的,但是针对这种格式一般的扩展名是 .jpeg、.jfif、.jpg、.JPG、或是.JPE。

x> 这个"档案"是什么意思?有点不懂了,等我整明白了再从这里解释下吧 ヾ(≧▽≦*)o

robots协议

Robots协议(也称为爬虫协议、机器人协议等)的全称是“网络爬虫排除标准”(Robots Exclusion Protocol),网站通过Robots协议告诉搜索引擎哪些页面可以抓取,哪些页面不能抓取。

首先robots.txt文件是一个文本文件,使用任何一个常见的文本编辑器,比如Windows系统自带的记事本,就可以创建和编辑它 。再者robots.txt是一个协议,他不是一个命令。robots.txt是搜索引擎中访问网站的时候要查看的第一个文件(这就解释了为什么爬虫日志里频繁出现robots.txt了,因为只要爬虫来访网站,第一个访问的就是你这个文件,不管存不存在)。robots.txt文件告诉蜘蛛程序在服务器上什么文件是可以被查看的。

当一个搜索蜘蛛访问一个站点时,它会首先检查该站点根目录下是否存在robots.txt,如果存在,搜索机器人就会按照该文件中的内容来确定访问的范围;如果该文件不存在,所有的搜索蜘蛛将能够访问网站上所有没有被口令保护的页面。百度官方建议,仅当您的网站包含不希望被搜索引擎收录的内容时,才需要使用robots.txt文件。如果您希望搜索引擎收录网站上所有内容,请勿建立robots.txt文件。

举一个不是很恰当的栗子:如果将网站视为一家酒店,来访的搜索引擎现在是"保洁阿姨",robots.txt就是主人在房间门口悬挂的“请勿打扰”或“欢迎打扫”的提示牌。这个文件告诉"保洁阿姨"哪些房间可以进入和打扫卫生,哪些房间因为存放贵重物品,或可能涉及住户及访客的隐私而不对"保洁阿姨"开放。但robots.txt不是命令,也不是防火墙,如同守门人无法阻止窃贼等恶意闯入者。

那为何需要用robots.txt这个文件来告诉搜索机器人不要爬行我们的部分网页呢?比如:后台管理文件、程序脚本、附件、数据库文件、编码文件、样式表文件、模板文件、导航图片和背景图片等等。说到底了,这些页面或文件被搜索引擎收录了,用户也看不了,多数需要口令才能进入或是数据文件。既然这样,又让搜索机器人爬行的话,就浪费了服务器资源,增加了服务器的压力,因此我们可以用robots.txt告诉机器人集中注意力去收录我们的文章页面。增强用户体验。

robots协议的作用

- 引导搜索引擎蜘蛛抓取指定栏目或内容;

- 网站改版或者URL重写优化时候屏蔽对搜索引擎不友好的链接;

- 屏蔽死链接、404错误页面;

- 屏蔽无内容、无价值页面;

- 屏蔽重复页面,如评论页、搜索结果页;

- 屏蔽任何不想被收录的页面;

- 引导蜘蛛抓取网站地图;

怎么书写robots.txt

robots.txt禁止收录协议写法(英文版):https://www.robotstxt.org/robotstxt.html

站长工具一键生成robots.txt:http://tool.chinaz.com/robots/

2 条评论

我们已收录贵站,欢迎回访,谢谢支持!

收录页短网址:https://eps.gs/1I2wkMM

谢谢 辛苦惹~